Erreurs humaines et défaillances organisationnelles

Les grandes catastrophes industrielles telles que Bhopal, Challenger, Tchernobyl, AZF ou Columbia nous rappellent que nous vivons près de systèmes complexes, de technologies à hauts risques dont il faut prévoir les défaillances techniques mais aussi humaines.

Un changement de paradigme

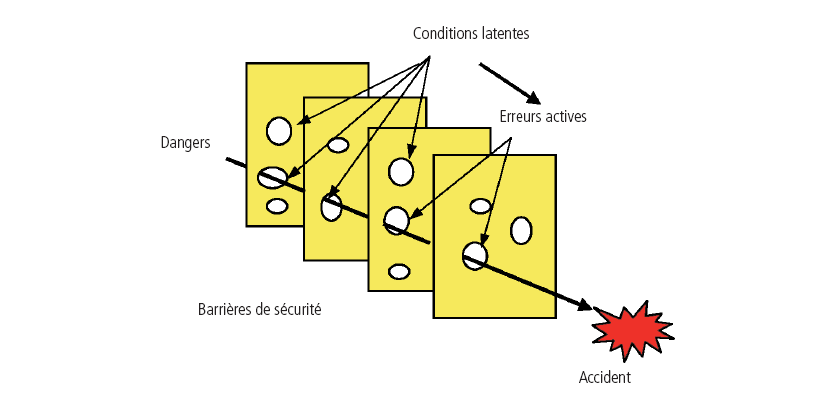

En matière de facteur humain, les ingénieurs, les ergonomes et les psychologues travaillent sur le risque d’erreur depuis les années 50. Les sociologues ne se sont mobilisés que vers le milieu des années 80, et tentent de comprendre la production d’erreurs non plus au niveau de l’opérateur mais à celui de l’organisation. Cette prise en compte du facteur humain rendue nécessaire par l’importance de l’erreur humaine dans la défaillance des systèmes aura donc suivi un cheminement par étapes.

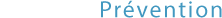

Constituée à l’origine de travaux de recherches en ergonomie portant notamment sur l’adaptation des pupitres de commandes, elle s’est orientée dès les années 60 vers la création de méthodes de prévisions d’erreurs humaines telle que THERP (Technic for human error rate prediction), et vers les évaluations prévisionnelles de fiabilité humaine (EPFH), généralisées après l’accident de Three Mile Island en 1979. On aurait pu en rester là si le comportement des opérateurs lors de l’accident de Tchernobyl n’avait laissé perplexes les spécialistes du facteur humain. Les travaux de James Reason ont ainsi montré que l’on ne peut comprendre ces accidents en se cantonnant aux processus mentaux de l’opérateur, les théories strictement cognitivistes étant impuissantes pour expliquer seules ces types de comportement. L’erreur active de l’opérateur ne se comprend qu’en référence aux erreurs latentes dans les systèmes, erreurs en sommeil, éloignées de l’opérateur et qui tiennent à de mauvaises décisions de conception, de maintenance ou de gestion (figure 1).

Figure 1. Modèle de l’accident de Reason (Reason, 1997).

Après l’accident de Three Mile Island, pour comprendre ce qu’il a qualifié d’accident systémique ou d’accident normal, Charles Perrow a ouvert la voie à de nombreux travaux. Parmi ceux-ci, les membres du groupe des HRO (high reliability organizations) (TR La Porte, KH Roberts, GI Rochlin) ont travaillé sur des organisations soumises à de fortes contraintes mais particulièrement performantes en matière d’accidents, telles que des porte avions nucléaires de l’US Navy, des centrales nucléaires... Il s’agissait d’identifier les caractéristiques intrinsèques à ces organisations permettant d’expliquer ces hautes performances. L’anthropologue américaine Diane Vaughan, après avoir travaillé sur l’explosion de la navette Challenger, a mis en évidence une lente dérive dans l’organisation de la NASA, ayant abouti à une routinisation de la déviance dans les années précédant l’accident. Les travaux de Mathilde Bourrier, sociologue française, rappellent entre autres que tout système complexe (y compris une centrale nucléaire) est avant tout une organisation normale, fondée sur des combinaisons de stratégies d’acteurs qui peuvent être à l’origine d’effets pervers comme vertueux.

Vingt ans de recherches au niveau des organisations ont donc permis d’éclairer ce qu’il est désormais convenu d’appeler les défaillances organisationnelles. Cependant, conjointement à ces travaux se pose le problème d’un développement de méthodes destinées à mieux connaître les défaillances des sites industriels et à en améliorer les performances.

Une offre méthodologique émergente et somme toute confidentielle

Jusque dans les années 80 et dans la continuité des théories cognitivistes, les méthodes restent en effet focalisées sur l’individu et les processus mentaux susceptibles de le conduire à l’erreur. THERP, SLIM-MAUD, le modèle SRK (skill-rules-knowledge) et l’OAT (operation action tree) en sont quelques exemples.

Les accidents des années 80 démontrent que le facteur humain ne peut à lui seul expliquer les phénomènes accidentels. Partant de ce constat, les ergonomes, les premiers, viennent élargir la palette des outils méthodologiques disponibles. Leurs méthodes restent centrées sur l’erreur humaine tout en s’intéressant pour la première fois aux facteurs de contexte qui influencent les processus mentaux de l’individu (stress, fatigue, température, procédures à disposition, formation reçue, etc.). L’enjeu se situe dès lors dans le couplage de l’opérateur à son environnement. C’est essentiellement pour et par le secteur du nucléaire que ces méthodes de « deuxième génération », comme les qualifie Erik Hollnagel, ont vu le jour. Cogent, Intent, Hitline, Sherpa et parmi les plus connues, Cream, Atheana (développée par l’autorité de sûreté nucléaire américaine) et Mermos (conçue par EDF en France) sont quelques exemples d’outils méthodologiques s’inscrivant dans cette logique.

Ces méthodes constituent les premiers pas vers des outils d’analyse appréhendant l’environnement organisationnel dans son ensemble. Dès les années 90, l’évolution de la compréhension des phénomènes accidentels relègue le modèle de l’homme considéré comme source d’erreur au second plan. En effet, le retour d’expérience montre que les opérateurs étaient en quelque sorte acculés à l’erreur, n’ayant d’autre choix que de faillir du fait de leur contexte de travail. Les méthodes développées dans la lignée de cette approche s’intéressent dès lors à l’environnement organisationnel de travail susceptible de conduire, de contraindre l’individu à l’erreur. Elles se concentrent en particulier sur les défaillances organisationnelles latentes, fruits de décisions prises dans le passé et dans les couches supérieures de la hiérarchie et se traduisant sur le terrain par des erreurs directes (ou actives). Citons pour illustrer ce courant méthodologique les méthodes Tripod, WPAM, Sam, I-Risk et Imas que nous pourrions qualifier de « troisième génération ».

Figure 2. Évolution des approches du management de la sécurité (adapté de Groeneweg, 2002).

Dans la logique d’une unité d’analyse grandissante (de l’individu à l’organisation), une nouvelle approche organisationnelle émerge depuis peu dans le domaine de la prévention. Cette approche propose de dépasser les frontières structurelles de l’organisation en considérant le système sociotechnique dans son ensemble. Elle raisonne en termes de barrières de sécurité (techniques, humaines, organisationnelles, procédurales) protégeant le système contre l’accident. L’analyse repose sur l’identification de ces barrières, puis sur l’évaluation de leur robustesse. Forthe, Athos ou Aramis sont quelques illustrations de cette « quatrième génération » de méthodes.

Force est de constater que ces méthodes n’ont pas toutes un caractère opérationnel – certaines sont restées au stade de prototype...

Tripod Delta, une approche proactive des défaillances organisationnelles

Tripod émane d’un programme de recherche initié en 1986 par le groupe Royal Dutch/Shell et mené conjointement par James Reason de l’université de Manchester (Royaume-Uni) et les chercheurs du laboratoire de psychologie expérimentale (Hudson, Wagenaar, Groeneweg) de l’université de Leiden (Pays-Bas). Reprenant les travaux de Rasmussen sur l’erreur humaine, les chercheurs s’intéressent aux conditions d’occurrence des accidents dans les systèmes à risques. Reason formalise au passage, dans le contexte du développement de la méthode, son célèbre modèle du « gruyère » (« Swiss cheese model ») qui en constitue le fondement théorique. Le modèle représente le système de défense de l’organisation contre les accidents comme un ensemble de barrières de sécurité redondantes, chacune de ces barrières pouvant présenter des défaillances, faiblesses matérialisées par un « trou » dont la conjonction peut provoquer un accident.

Les concepteurs de la méthode proposent dès lors de remonter jusqu’aux origines profondes de ces défaillances, jusqu’aux erreurs latentes susceptibles de s’exprimer sous différentes formes de défaillances opérationnelles, de situations dangereuses et de venir fragiliser sur le terrain les différentes barrières de défense mises en place. À partir d’un long travail de retour d’expérience mené par Leiden, en particulier sur des accidents ou incidents réels, les chercheurs proposent de modéliser ces différentes sources de défaillances sous la forme de 11 facteurs organisationnels (voir encadré).

Les 11 facteurs organisationnels de Tripod |

Conception (CP) Qualité de la conception du lieu ou poste de travail, des équipements en termes d’ergonomie et de fonctionnalité |

Selon la méthode, certains de ces facteurs sont véritablement liés aux activités, opérations et à la nature du système organisationnel (les facteurs spécifiques) alors que d’autres comme la formation, la communication ou le système procédural semblent plutôt indépendants du système étudié (les facteurs génériques).

La théorie Tripod a donné lieu au cours de son développement à deux types d’outils méthodologiques selon le mode réactif ou proactif d’analyse : l’outil Beta pour l’analyse a posteriori d’accidents et l’outil Delta, que nous décrirons rapidement, pour la version proactive.

L’outil Tripod Delta évalue la performance ou la défaillance de chacun des facteurs organisationnels de risques à l’aide d’un questionnaire individuel anonyme distribué à l’ensemble des membres de l’organisation (depuis la direction jusqu’aux opérateurs de première ligne, en passant par les intérimaires et les sous-traitants). L’étude permet ainsi d’évaluer le niveau de contrôle de l’organisation par rapport à chacun de ces facteurs et d’analyser ses défaillances selon les perceptions de chaque membre du système. L’expertise repose ainsi sur les membres de l’organisation qui, selon la théorie Tripod, sont les mieux placés pour faire émerger les défaillances provenant de l’organisation.

Les questions reposent sur des indicateurs qui permettent à la personne participant à l’étude de faire le lien avec sa propre connaissance ou expérience du système organisationnel (exemple d’indicateur pour le facteur « Procédure » : « Au cours des trois derniers mois, êtes-vous tombé sur des plans qui n’étaient pas à jour ? »). Ces indicateurs permettent pour certains d’analyser les pratiques informelles au sein de l’organisation.

L’enquête repose sur un certain nombre de questions issues d’une base centrale de questions (la « Delta Base ») testées et validées. Elles sont choisies en concertation avec le site analysé en fonction de ses spécificités (structure organisationnelle, taille, activités, etc.).

L’étude conduit à une analyse des points forts et faibles décelés pour chaque facteur organisationnel, mais aussi à une analyse des différences de perceptions entre les différents niveaux hiérarchiques et entre les différents services ou départements de l’entreprise. L’étude se montre également intéressante pour étudier l’influence d’un changement organisationnel (par exemple, une restructuration) sur la sécurité ou pour l’étude de la performance organisationnelle des différents sites d’un même groupe (benchmark interne). La méthode se trouve à ce jour à un stade de large utilisation et diffusion avec plus de 300 sites utilisateurs et plus de 20 000 personnes ayant participé à l’étude. Elle a été appliquée dans différents secteurs d’activité : pétrolier (secteur d’origine), ferroviaire, maritime, chimique, pétrochimique, administratif, fabrication, nucléaire, aussi bien que dans différents environnements culturels : Pays-Bas (pays d’origine), Grande-Bretagne, Norvège, Danemark, Canada, Thaïlande, Malaisie, Russie).

Pour en savoir plus

Bieder C (2006). Les facteurs humains dans la gestion des risques – Évolution de la pensée et des outils. Éditions Lavoisier.

Bourrier M (1999). Le nucléaire au défi de l’organisation. Paris, Presses universitaires de France.

Bourrier M (sous la direction de) (2001). Organiser la fiabilité, Paris, l’Harmattan.

Cambon J. Guarnieri F (2008). Maîtriser les défaillances des organisations en santé et sécurité au travail – La méthode Tripod. Collection SRD, Éditions Lavoisier.

Groeneweg J (2002). Controlling the controllable. Preventing business upsets, fifth edition. Global Safety Group Publication. pp. 1-528.

Perrow C (1984). Normal Accidents, Living with High risk technologies. New York, NJ: Basic Books.

Reason J (1993). L’erreur Humaine. Paris, PUF.

Reason J (1997). Managing the Risks of Organizational Accidents. Ashgate. 252 p. Cambridge University Press.

Rochlin G (1988). Technology and adaptative hierarchy: Formal and informal organization forvflight operations in the US Navy, Working paper N° 88-18, Institute of Governmental Studies, University of California, Berkeley, CA.

Vaughan D (1996). The Challenger Launch Decision. Chicago, IL: The University of Chicago Press.

Villemeur A (1988). Sûreté de fonctionnement des systèmes industriels, Paris, Éditions Eyrolles.

Partagez et diffusez ce dossier

Laissez un commentaire

Votre adresse de messagerie ne sera pas publiée.